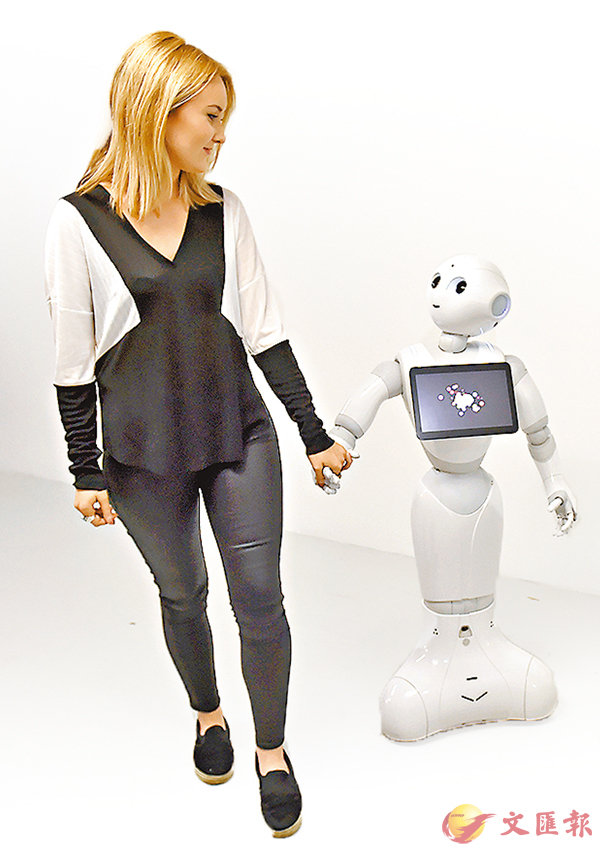

■當機械人的應用愈來愈廣,人類遲早會過分依賴。資料圖片

■當機械人的應用愈來愈廣,人類遲早會過分依賴。資料圖片隨着人工智能(AI)技術日新月異,愈來愈多人類的工作已由機械人取代。但隨着AI涉及歧視的個案頻生,要求機械人遵守人類道德規範的聲音日益高漲。英國標準協會(BSI)早前發佈指引,規範科研人員需設計合乎道德的機械人,規定機械人不應用作殺戮或傷害人類,而它們的行為必須由人類負責。

部分地區的警方已開始採用AI技術,辨別構成潛在威脅的可疑人物,但機械人學習時使用的數據可能存在偏頗,導致AI出現歧視,例如AI系統會偏好中年白人男士,少數族裔特別容易受針對。

過分依賴 人類可能被騙

科學家指,深度學習系統透過互聯網學習,問題在於這些數據本身存在偏頗,而機械人又照單全收,結果出現性別及種族歧視的傾向。BSI指引提出,當機械人的應用愈來愈廣,人類遲早會過分依賴,引發嚴峻社會問題。設菲爾德大學教授夏基稱,如果長時間與機械人合作,漸漸習慣由它們提供正確答案,人類最終會忽略機械人出錯的可能。

根據BSI的指引,設計員應注重透明度,讓外界了解機械人的運算情況。不過,現時的AI太複雜,以深度學習系統為例,有別於由設計員編寫運作程序,機械人會自行嘗試數百萬次,直至發展出一套有效的策略,設計員根本無從得知它的「思考」過程。

指引亦提出一些較少人探討的問題,例如應否鼓勵機械人與人類產生情感聯繫。研究發現,在託兒所引入小型機械人陪伴兒童,會令孩子們「愛」上機械人,甚至認為它們比寵物更具靈性。有學者指出,當人類與機械人的感情日漸親密,不排除出現人類被機械人無意中欺騙的事件。 ■《衛報》